Mit kell tudnod a felvételi jelentkezésről? Hogyan tervezd meg a megjelölt szakok sorrendjét? Hogyan ütemezd teendőidet a 2026. február 15-i jelentkezési határidőig?

Mit kell tudnod a felvételi jelentkezésről? Hogyan tervezd meg a megjelölt szakok sorrendjét? Hogyan ütemezd teendőidet a 2026. február 15-i jelentkezési határidőig?

Miért kellene a világ minden szövege a neurális nyelvi modellek tanításához, amikor egy gyermek jóval kisebb szómennyiségből hatékonyan megtanulja anyanyelvét? A nagy AI cégek nyelvi modelljeinek adatpazarlása és ezer tonnákban mérhető CO2 kibocsátása helyett az emberi gondolkodásból kiindulva lehetne hatékonyabb modelleket készíteni? Az SZTE Informatikai Intézetének Számítógépes Algoritmusok és Mesterséges Intelligencia Tanszékén a nyelvi modellek létrehozásának új irányait kutatják, közöttük egy alternatív módszert, amelyre Dr. Berend Gábor egyetemi docens idén elnyerte az MTA Bolyai kutatói ösztöndíját. Az SZTE mesterségesintelligencia-kutatója a nemzetközi Baby LM Challenge 2023-as kiírásában 120 beküldött modellből második helyet ért el. 2020-ban publikált módszere évekkel megelőzte az Open AI-t és a Google-t, amelyek 2024 nyarán szellőztették meg hasonló fejlesztésüket.

– Ha jól értettem, az ön Bolyai-ösztöndíjas kutatási célja kisebb, gazdaságosabb nyelvi modellek megalkotása, méghozzá olyan módszerekkel, amelyek jobban megközelítik az emberi megértést. Ez éppen ellentétes irány, mint amerre a nagy techcégek milliárdos költségű, hatalmas szövegmennyiségen tanított modelljei fejlődtek. Mi indokolja a kevesebb szöveggel tanított modelleket? Elfogyhatnak az új szöveges adatok a világban?

– Az adatínség már be is következett, hiszen az igazán nagy nyelvi modellek szinte a teljes internet anyagából tanultak. Az elérhető adatok kimerültek, szerintünk most a minőségre kell, hogy áttevődjön a kutatás hangsúlya. Lehet, hogy nem trilliárdnyi szóból álló adatkészletek kellenek már a modellek tanításához, hanem egy okosan megválasztott szövegmennyiség, amelyet hatékonyan használunk fel. A nyelvi modellek a szövegek értelmezésére és feldolgozására, vagyis egy emberi képesség szimulálására törekszenek. A nemzetközi AI-cégek révén megismert nagy nyelvi modellek gépi tanításra alkalmazott célfüggvényei mégis figyelmen kívül hagyják az emberi megértés sajátosságait. Ez idézi elő azt a helyzetet, hogy a nagy nyelvi modellek drágán, rendkívüli adatpazarlással és alacsony hatékonysággal tudják elérni az emberi megértés szimulációját. Mi úgy gondoljuk, az emberi gondolkodástól inspirált módszerek hozzák el a gazdaságosabb és széles körben elérhető nyelvi modellek idejét. Az elnyert Bolyai kutatói ösztöndíj programjának célja olyan alternatív gépi tanulási módszer fejlesztése, amely az emberi felfogás hatékonyságából indul ki, és alacsonyabb költségű, adathatékony modelleket eredményez.

– Szeretném, ha ebben a beszélgetésben tisztáznánk, hogy egy módszer, amely az emberi képességekből indul ki, hogyan tesz hatékonnyá egy modellt. Milyen hibákat rejt, amikor egy modell nem az emberhez hasonlóan dönt?

– A klasszikus maszkolt nyelvi modellezés (MLM) úgy történik, hogy a gépi tanításnál a modellnek 100 milliárdos mennyiségben adunk be mondatokat, és ezeknek bizonyos mennyiségű szavát kitakarjuk. A nyelvi modell célja, hogy képes legyen megállapítani, a kitakart szó helyén pontosan milyen szó állhatott. Tegyük fel, hogy azzal a mondattal találkozik, hogy „Reggel ettem egy finom palacsintát”. Itt a palacsinta szót takarjuk ki, ezt kell kikövetkeztetnie a modellnek. A hagyományos előtanításnál elvileg annál kevesebb a hiba, minél nagyobb valószínűséget tulajdonít a palacsinta szónak és pontosan annak. Csakhogy ezen a ponton törékeny lesz a modell. Azt fogja helyesnek tekinteni, ha a maszkolt helyre 100 százalékos valószínűséggel a palacsinta szó kerül. Emberi felfogással viszont érezzük, hogy a burrito, az omlett, a tejberizs és sok minden tud még finom reggeli lenni. A klasszikus előtanítás célfüggvénye számára az omlett szó mégis éppen olyan valószínűtlen, mint ha a csavarhúzó kerülne oda. Itt tetten érhető, hogy az egyes tanulási lépései mennyire nem tükrözik az emberi gondolkodásmódot. A mi módszerünk viszont arra törekszik, hogy előtanításkor a maszkolt palacsinta szó helyére a „reggelikor elfogyasztható étel” fogalmi kategória kerüljön. Az eljárásunk során egy segédmodellel előbb a szavakhoz kötődő rejtett fogalmi kategóriákat szeretnénk automatikusan felállítani.

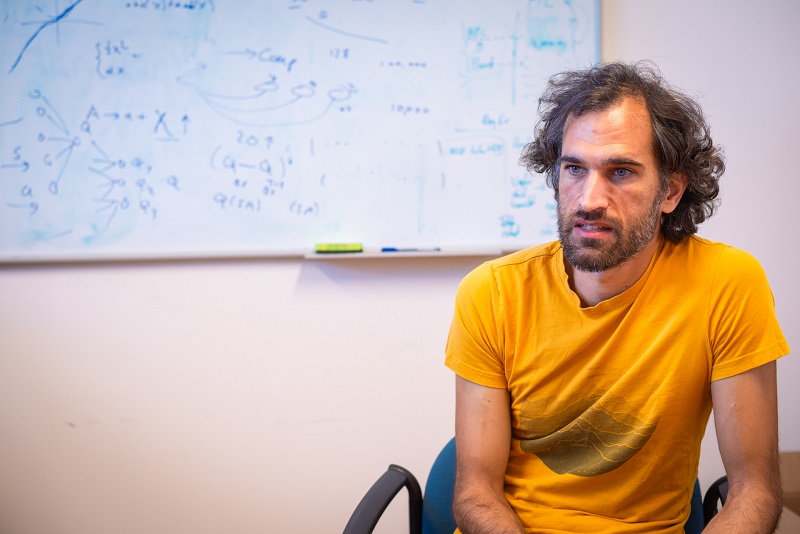

Dr. Berend Gábor, az SZTE Informatikai Intézet Számítógépes Algoritmusok és Mesterséges Intelligencia Tanszék egyetemi docense. Fotó: Kovács-Jerney Ádám

– Hogyan ragadható meg az emberi és a gépi gondolkodás különbsége matematikai úton?

– Kezdjük onnan, hogy a szövegből készülő számítógépes reprezentációkat vektoroknak, vagyis hosszú számsoroknak kell elképzelni. Korábban szerettünk úgy gondolni ezekre a vektorokra, hogy minden szám elkódolja az illető szó által fedett dolog egy-egy tulajdonságát. Ez az értelmezés azonban tévesnek bizonyult, mert így a vektor minden pozícióján nem-nulla érték állna, ami nem felel meg az emberi gondolkodásnak. Olyan ez, mintha mi, emberek minden egyes dologról, minden egyes létező tulajdonsága szempontjából véleményt tudnánk alkotni. Mondjuk, az ajtókilincs ízletességéről is lenne véleményünk. Sokkal közelebb áll az emberi gondolkodáshoz, ha a reprezentáció vektorai számsorok ugyan, de nagyon sok pozíción nullák, mert például az ajtókilincs ízletességéről nincs értelme véleményt formálni. Az így kapott mintázatban egy dologra általában nagyon kevés tulajdonság teljesül, a tulajdonságok pedig általában nagyon kevés dologhoz társulnak. A kutyához rendelhető tulajdonságokat például két kezünkön meg tudnánk számolni: házőrző, hűséges, szőrös, négylábú, és nagyjából tíz tulajdonság után kifogynánk az ötletből. Viszont az említett vektorok ezernél is több dimenziósak. Ebből született meg a kutatási ötletünk: tegyük a vektorokat olyanná, hogy az ezer dimenzióból csak néhány tucat legyen nullától eltérő, és ezeket ruházzuk fel a már említett fogalmi kategóriák jelentésével. Ha egy bizonyos dimenzió jellemzően a szőrös dolgok mentén vesz fel nullától különböző értéket, akkor azt mondhatjuk, hogy ez a koordináta a dolgok szőrösségének az elkódolásáért felelős. Ezt az alternatív előtanítási eljárást maszkolt látens szemantikai modellezésnek (röviden MLSM) neveztük el. Angol és magyar nyelvre is következetesen jobb eredményeket adott, mint a klasszikus maszkolt nyelvi modellezés.

– Miért van az, hogy a nagy nyelvi modellek válaszai mégis egészen emberinek tűnnek?

– Úgy érezzük, hogy a nagy nyelvi modellek már szinte közel állnak az emberi képességekhez, de ez csalóka, ezekkel a modellekkel már csak a betanításuk végén találkozunk. Betanított állapotban a modellek helyettesítési valószínűségei már eléggé hasonlóak az emberi gondolkodáshoz. Csakhogy ezt a javulást a nagy nyelvi modellek annak köszönhetik, hogy a tanítás rendkívül hosszú folyamata során kiátlagolódnak a túlságosan sarkos valószínűségek. Az ilyen modellek csak igen erőforráséhes és hatalmas mennyiségű tanítószöveget igénylő tanítás után közelítenek a valósághoz. A legújabb Llama 3.1 modellek tanítása 13 trilliárd szövegszavon történt. A legnagyobb, 405 milliárd paraméterrel rendelkező modelljük létrehozása körülbelül 30 millió GPU-óra számítási kapacitással és 9000 tonna CO2 kibocsátással járt. A zárt modellek méreteit ráadásul nem is ismerjük. Mi a Bolyai-ösztöndíj keretében azt tűztük ki, hogy a modelljeink mintahatékonyan tanulva legyenek eredményesek. Vagyis a problémát ne drága erőforrásokból oldjuk meg és az emberi kognitív jelleg ne csak mint mellékhatás következzen a végtermékből!

– Jól értettem, hogy előbb segédmodelleken tárják fel a szavak jelentésbeli hasonlóságait, és aztán következik a modell tanítása? Egy kétfázisú eljárás is lehet hatékony?

– Igen. A mostani módszerünkben szükség van egy legalább részlegesen betanított segédmodellre, és persze itt előjön a tyúk és a tojás problémája: úgy akarunk hatékonyan nyelvi modellt tanítani, hogy ahhoz már előtte be kell tanítanunk egy modellt. Ez negatívumként is értelmezhető, de gyakorlatias szempontból egyáltalán nem túlzó elvárás, hogy rendelkezésre álljon egy már betanított nyelvi modellünk, hiszen ilyeneket ezerszámra le lehet tölteni a netről. Ha a gyermeki nyelvtanuláshoz hasonlítjuk, ott is van egy szülő, aki terelgeti a nyelvtanulást. Természetesen elegánsabb lenne, ha a fogalomalkotás on the fly történhetne, menet közben elképzelhető, hogy még hasznosabb fogalmi struktúrák alakulhatnának ki. Ez a Bolyai kutatói ösztöndíj második évének célkitűzése lesz.

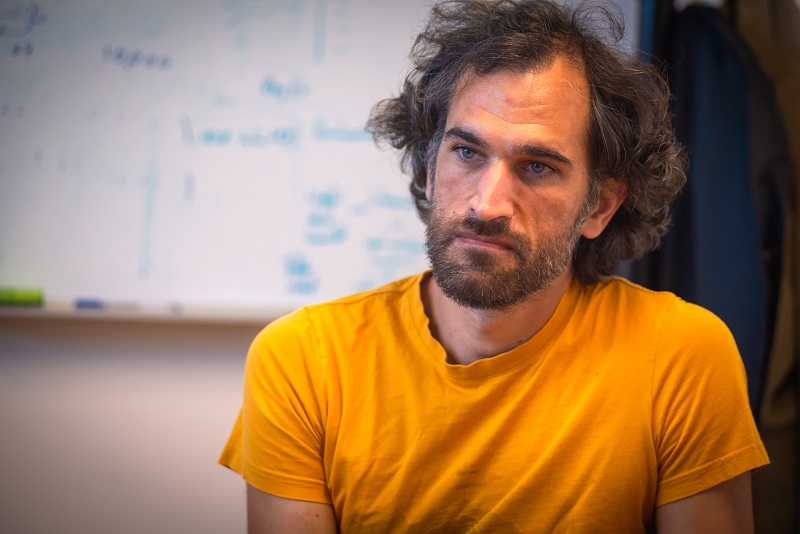

Fotó: Kovács-Jerney Ádám

– Mit kell tudni a BabyLM Challenge versenyről, amelyen tavaly második lett a modelljük?

– A versenyt kifejezetten a nyelvi modellek tanításának adattakarékos optimalizálására írják ki, mégpedig azzal a céllal, hogy az új eljárások az emberi gondolkodás hatékonyságából merítsenek. A kiírás 2023-ban a tanításra felhasználható szövegmennyiséget 10 millió szövegszavas korpuszra korlátozta. Összehasonlításul, 100 millió szavas az a szövegmennyiség, amivel egy gyermek 13 éves koráig találkozik, a 2020-as GPT 3 pedig 300 billió szóból tanult. A verseny kinyilvánított célja az is, hogy demokratizálja, közkinccsé tegye a modellek előtanításával kapcsolatos technológiákat, mivel ezt a területet jelenleg a nagy MI cégek uralják. A BabyLM Challenge szervezői élenjáró nemzetközi egyetemeken, az MIT-n, a New York-i Egyetemen, a zürichi EHT-n, vagy a META AI-nál (korábban Facebook AI) dolgozó mesterségesintelligencia-kutatók.

– Végső soron mitől függ a modellek tanításának adattakarékossága?

– A Baby LM verseny elsősorban a szövegmennyiségre fókuszál. Ezen a versenyen érvényes megoldás, ha valaki kevés szövegen, de rengeteg ideig tanítja a modellt. Azonban a hosszas tanítás – a tanításra használt szövegmennyiség növelése nélkül – egy ponton túl nem célravezető, így pusztán a hosszabb ideig történő tanítással nem lehet valódi sikereket elérni. Először 2022-ben próbálták meg feltérképezni a nagy nyelvi modellek skálázódási törvényszerűségeit: ebben a munkában nem a felhasználható szövegmennyiséget, hanem a számítási kapacitást fixálták le, és azt találták, hogy több tanítószöveg használata esetén akár kevesebb paraméterrel rendelkező modellek is képesek lehetnek elérni nagyobb társaik teljesítményét. Ez volt az első szisztematikus kísérlet, ami megvizsgálta, hogyan viszonyul a tanítószövegek mennyisége a modellben található paraméterek számához, és e kettő függvényében mi az ideális tanítási hossz. Kiderült, hogy kényes egyensúlyban van ez a három tényező. Ha kevesebb ideig tanítjuk, nem érünk el a csúcsra, ha tovább tanítjuk, nem fog számottevően javulni a teljesítmény. Kevés szöveget hiába tanítunk fél GPU-évig, az nem lesz kifizetődő. Mi ezt próbáljuk meg kicsiben, 10 vagy 100 millió szövegszavon eljátszani. A mi modelljeink 2-3 nap alatt betanulnak, szemben az igazán nagy nyelvi modellekkel, amelyeknél a betanulás összesített ideje GPU-években, sőt a legnagyobb modellek esetén GPU-évezredekben mérhető.

– Az önök törekvése mögött pusztán adatgazdaságossági elgondolás van, vagy inkább az emberi kognitív képességek felhasználását kutatják?

– A kettő valamennyire együtt jár. A minőségre kihatással lehet, ha a modell az emberi gondolkodást figyelembe véve készült. A nyelvi modelleket, és általában is a mesterséges intelligencia modelleket a nagyfokú törékenység jellemzi, vagyis a robusztusság hiánya. Az ember gondolkodása viszont kevésbé érzékeny a bemeneti adatokra. Az ember is törékeny a vizuális csalódásokra vagy a szintaktikai többértelműségekre, de még a helytelen döntései is elfogadhatók. Mit válaszolnánk arra a kérdésre, hogy „Fölpróbálhatom azt a ruhát a kirakatban?”. „Persze, de van próbafülkénk is!” Az ilyen félreértés az emberi megértést megakaszthatja, de nem állítja meg. A gépek viszont emberi szempontból véve buta módon is képesek helytelenül viselkedni.

Fotó: Kovács-Jerney Ádám

– Hisz abban, hogy tisztán az emberi értelem sajátosságain alapuló modellt lehet létrehozni?

– Szerintem ez lehetséges, de egyáltalán nem biztos, hogy ez a cél. Az emberi gondolkodásnak gyengéi is vannak, mi pedig hatékony eszközt szeretnénk csinálni. A cél az, hogy a modellünk bizonyos hasznos feladatokban emberi módon „viselkedjen”, de ahol erre nincs szükség, ott haladja meg az emberi gondolkodást. Például az emberi intelligenciára jellemző induktív torzításokat vezetünk be, hogy a emberi kognitív vonásokat csempésszünk a tanításba. Az induktív torzítás az emberi gondolkodásnak az a hajlama, hogy információhiányos helyzetben előfeltevéseket részesít előnyben, emiatt gyorsabban felfogjuk a komplex helyzeteket és gyorsabban döntünk. A modellek így nem szakadnak el teljesen attól, ahogyan az emberek formálják a gondolataikat. Másfelől viszont nem hiszem, hogy a kognitív tudósok és pszichológusok által alkotott mentális modelleket át kellene ültetnünk. Nem biztos, hogy a gép számára is az a fogalmi struktúra a legideálisabb, ami az embereknek. Lehet persze ennek a fogalmi hierarchiának egy olyan magja, ami közös.

– Az emberi érzelmeknek lehet bármilyen szerepe a tanításnál?

– Én az érzelmeket teljesen idegennek tartom az algoritmusok világától. Olykor hajlamosak vagyunk érzelmeket belelátni a gépekbe, noha ezeket valójában egy célfüggvény irányítja. Ezt a célfüggvényt meg lehet próbálni okosabban csinálni, vagy olyanra, hogy tényleg emlékeztessen az emberi fogalomalkotásra, de az érzelmeknek nem látom a szerepét.

– Más szóval, nem homunkulusz készül a műhelyükben, ahogyan azt a nem tudományos közönség időnként hajlamos feltételezni…

– Időnként a tudományos közönség is hajlamos erre. Már az 1970-es években olyan képességekkel ruházták fel a nagyon egyszerű szabályalapú társalkodó robotokat, amilyenekkel nem rendelkeztek. Ezt Eliza-effektusnak hívják, ami arról az 1960-as években az MIT-n megalkotott programról kapta a nevét, amit az ember és gép közötti interakció tanulmányozására hozták létre. Noha ez a program csupán egyszerű szabályok alapján működött, mégis sokan túlzott kognitív képességeket tulajdonítottak neki. Ráadásul ma már időnként tényleg annyira meggyőző a nagy nyelvi modellek kimenete, hogy emberi gondolkodásra utaló szóhasználattal írjuk le a működésüket. Szoktam hallani, hogy „a gép rossz választ adott, de aztán korrigáltam, és ráeszmélt, hogy hibázott”. Ez a fajta interpretáció nem más, mint megfigyelői torzítás (observer bias), hiszen egyszerűen annyi történt, hogy a rossz választ nem a valóságnak megfelelően értelmezte a tesztelő. De azért jegyezzük meg a jelenség kapcsán, hogy az ember által megtervezett gépi tanítás tényleg nyomot hagy a nyelvi modelleken; például „szeretnek” helyeselni az embernek. A tanításuk ugyanis emberi visszacsatolások alapján történt, és a helyeslő viselkedést rendszerint díjazzák az emberek. Igazából az emberi intelligencia köszön vissza sokszor a gép válaszában, mert ennek a válasznak az az előzménye, hogy tanításkor kijavítottuk őt.

– Ön problémának tartja, hogy a mesterséges nyelvi világ kezd keveredni az emberekével? Felismeri, ha gépi szöveget olvas?

– Gyakran érzem úgy, hogy az olvasott szöveget valószínűleg gép írta, bár ez is lehet megfigyelői torzítás. Sajnos akár tudományos közleményeknél, bírálatoknál is. Ezzel kapcsolatban születtek tanulmányok, amelyekben azt próbálták feltérképezni, hogy a konferenciákra beérkezett cikkek bírálatainak mekkora hányada készülhetett gépi segítséggel. Tíz százalék körüli lett az eredmény. A kutatás alapját az adta, hogy bizonyos konferenciák publikusan elérhetővé teszik a bírálók által írt szövegeket, és statisztikai eltérést tapasztaltak a nagy nyelvi modellek berobbanása előtti és utáni bírálati szövegek nyelvhasználati mintázataiban. Van egy-két szó, amit ha az ember meglát a szövegben, kigyulladhat benne a vörös lámpa, hogy ezt jó eséllyel a gép írta. A médiában elfogadható eszköznek tartom a fordításra, összefoglalásra, de csak akkor, ha a tényeket képesek ellenőrizni a szerkesztők.

– Az önökén kívül milyen módszerek vannak még a modellek tanítására, amelyek az emberi tanulásból indulnak ki?

– Az egyik módszerrel olyan egyszerűségű szövegeket generáltatnak, mint amit egy legfeljebb 10 éves gyerek formálna, és ezeken tanítják a modellt. Azt találták, hogy ilyen szövegből viszonylag kevés is elég volt a tanuláshoz. A curriculum learning vagy fokozatos tanulás elnevezésű technika esetén pedig egyre növekvő nehézségű szöveges példákkal tanítják a modellt. Ez az irányzat azt állítja, hogy a tanítószövegek fejlődéstörténete javítja a tanulást, hasonlóan ahhoz, ahogy egy gyermek is fokozatosan tanul egyre bonyolultabb dolgokat. A tanulás minőségét célozzák még a különböző multimodális fejlesztések is, azzal a jeligével, hogy egy kép többet mond ezer szónál. Egyébként a gyermek is találkozik képekkel, mozgóképekkel tanulás közben.

– Gyakran szóba kerül, hogy nem tudni pontosan, mi történik a gépi tanulás közben, amikor az algoritmus a tanítószövegekben lévő mintázatokat azonosítja. Az önök módszere közelebb visz a megfejtéshez?

- Azt reméljük, hogy igen. Ha a fogalmi kategóriákat megfelelő módon sikerülne beazonosítanunk, akkor a nyelvi modellek viselkedését is lehetne ezzel irányítani. Például, ha egy bizonyos szövegformálásba belekerült a vulgaritás fogalmi kategóriája, akkor ezt a fogalmat megpróbálhatjuk kiütni. Sikeresen beazonosíthatjuk, hogy a reprezentációban melyik a „nem irodalmi” szóhasználatért felelős komponens, és célzottan megpróbálhatjuk udvarias kifejezésre változtatni, amit a modell szlengben fogalmazott. Ehhez pontosan az kell, hogy a modellek feketedoboz jellege megszűnjön, és talán éppen a fogalmak beazonosítása és feltérképezése segíthet minket ehhez.

Fotó: Kovács-Jerney Ádám

– Az SZTE-MTA Mesterséges Intelligencia Kutatócsoport más nyelvtechnológiai kutatásai is kapcsolódnak a nyelvi modellekhez?

– A kutatócsoportban általában véve azzal foglalkozunk, hogy jobban megértsük a nyelvi modellek működését és a felkészítésükhöz hatékonyabb módszereket keressünk. A kutatási irányok is azt tükrözik, hogy e hatékonyság kiaknázásával szeretnénk eljutni egy következő minőségi szintre. Egyik ilyen irány az a feltevés, hogy a nyelvi modellek robusztussága és a tanítási hatékonyság kéz a kézben jár. Elvégre az ember gondolkodása is robusztus, új helyzetekben jól tud mintákat felismerni, és ezt nagyon kevés erőforrásból teszi meg, a mesterségesintelligencia-modellek tanítópéldáinak töredékéből. Ezért egyik csoportunk, Jelasity Márk vezetésével azt vizsgálja, hogyan lehet javítani a modellek robusztusságán.

Egy másik kutatási irányunk a modellek konzisztenciájával foglalkozik. Azt szoktam mondani, minket alkalmilag az sem zavar, ha egy nyelvi modell téved, csak tévedjen következetesen. Ha azt állítja, hogy „Olaszország fővárosa Párizs”, majd pedig azt, hogy „az Eiffel-torony Olaszország fővárosában van”, ez konzisztens viselkedés: a fővárost eltévesztette, de azt jól tudja, hogy Párizsban található az Eiffel-torony. A mi törekvésünk, hogy ezt a konzisztenciát kikényszerítsük a modellekből, persze az elkövetett hiba nélkül. Egyáltalán nem biztos, hogy ez a vállalkozás egyáltalán lehetséges, de az is hasznos információ lesz, ha bebizonyosodik, hogy nem sikerülhet.

A nyelvi modelleket a világról alkotott ismereteik és az asszociációs képességeik szerint is vizsgáljuk. Sokan ismerik azt a játékot, amelyben a Wikipédia gráfján két random szócikk között kell hatékonyan elnavigálni, mondjuk Jeanne d'Arc-tól a Covid világjárvány szócikkéig. Az emberek ezt a feladatot elég jól meg tudják oldani, a nagy nyelvi modellek viszont időnként buta hibákat követnek el. A Wikipédián előfordul, hogy egy szócikken olykor saját oldalára mutató link van; az ember gyorsan felismeri, hogy nem éri meg ugyanazon az oldalon maradni. A kipróbált nyelvi modellek közül viszont még akár a legmodernebbek is elkövetik olykor azt a hibát, hogy hurokba kerülnek. Ez is mutatja, előfordul, hogy az emberi gondolkodásra egyáltalán nem jellemző módon hibáznak.

A csoporton belül Farkas Richárd vezetésével az úgynevezett retrieval-augmented generation, vagyis információ visszakereséssel megtámogatott szöveggenerálással foglalkoznak. Ez az eljárás a nyelvi modellek pontosságát külső forrásokból származó tényekkel próbálja növelni. A tanítószövegek között ugyanis lehetnek olyanok is, amelyek nem eléggé pontos információt tartalmaznak vagy éppenséggel tévesek. A modell hallucinációjának nevezzük, amikor ilyen tévedést tanul meg, például azt állítja, hogy a kutya ízeltlábú. Az eljárás abban áll, hogy mielőtt a modell választ generálna, egy háttérszövegtárból kikeressük azokat a hiteles szövegrészeket, amelyek relevánsak lehetnek a felhasználói igényhez, és ezek alapján generáljuk a választ.

– Az OpenAI idén nyáron az önök módszeréhez nagyon hasonló fejlesztési „újdonságot” jelentett be. Mit gondol erről?

– A nagy AI cégek valóban nemrég álltak elő azzal, hogy a nagy nyelvi modellek fogalmi hierarchiáját lényegében a miénkkel megegyező módszerrel kezdik el feltérképezni. Mi saját eredményként 2020-ban publikáltuk először, hogy a ritka nem-nulla értékű vektoros reprezentációk alkalmasak lehetnek a szavak jelentésének emberi fogalmak mentén történő meghatározására. Ebben a cikkben a manapság divatosaknál kisebb, de 2020-ban még nagynak számító 300 millió paraméteres modelleken mutattuk be az eljárást. Az idei bejelentések abban mutatnak túl ezen, hogy az azóta megnövekedett több tíz (vagy esetenként száz) milliárd paraméteres modellekre is fölskálázták az eljárást – amire nekünk nem volt erőforrásunk. Nagy különbség azonban, hogy ők ezt csak leíró jelleggel végzik el, és megálltak ezen a szinten. A közleményeikben meg is jegyzik, hogy a módszerük hátránya, hogy nem igazán tudják a kapott eredményeket a modellek létrehozásába visszacsatolni. Mi annyival előttük járunk, hogy ezt a módszert az új modellek létrehozásánál is alkalmazzuk. Más kérdés, hogy akkora számítási kapacitással lehet, hogy hamar utolérnek minket, de tény, hogy mi már 4 éve elkezdtük bejárni azt az utat, amelyen a nagy AI cégek első lépéseiket most tették meg.

Panek Sándor

A borítóképen: Dr. Berend Gábor, az SZTE Informatikai Intézet Számítógépes Algoritmusok és Mesterséges Intelligencia Tanszék egyetemi docense. Fotó: Kovács-Jerney Ádám